在当今的科技领域,HBM(高带宽存储器)芯片的发展势头极其迅猛,这其中AI和GPU对HBM芯片的需求起到了关键的推动作用。亿配芯城在此为您详细解读。

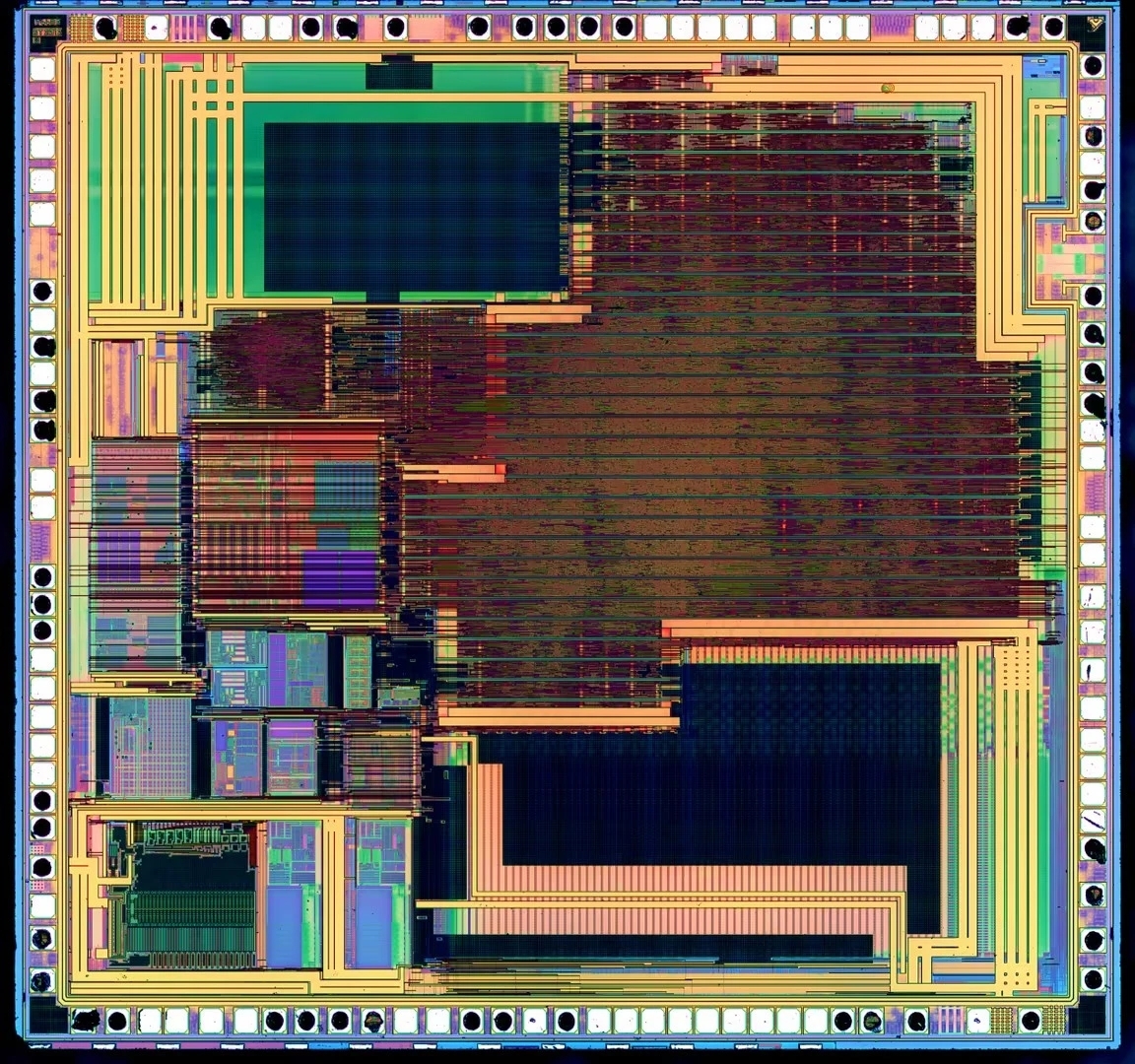

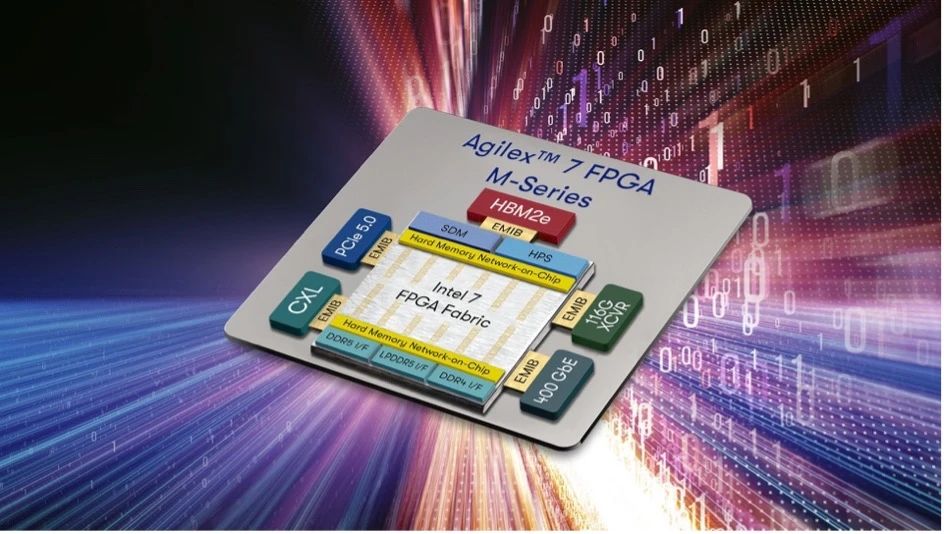

随着人工智能的蓬勃发展,训练和运行复杂的AI模型需要处理海量的数据。而GPU作为AI计算的核心硬件,对存储器的带宽和性能提出了极高的要求。HBM芯片通过创新的三维堆叠技术,实现了极高的存储密度和带宽,正好满足了这一迫切需求。例如,在大规模的图像识别和自然语言处理任务中,HBM芯片能够让GPU迅速获取所需的数据,从而显著提升计算效率和准确性。

从市场规模来看,根据相关数据显示,2023年全球HBM市场规模约为43亿美元。而市场调研机构Trendforce指出,受AI服务器需求的推动,2023年全球HBM需求量将增近六成,达到2.9亿GB,2024年将再增长30%。另据HBM专家预测,2024年HBM市场规模将达到169亿美元,约占DRAM整体产值的20%,且HBM3的占比会达到60%。到2025年,HBM整体市场有望达到20亿美元以上。更有甚者,如知名研究机构Mordor Intelligence预测数据显示,HBM存储产品的市场规模预计将从2024年的约25.2亿美元激增至2029年的79.5亿美元,预测期内(2024-20289年)复合年增长率为25.86%。

在这一发展浪潮中,亿配芯城始终密切关注HBM芯片的动态,为您提供优质、可靠的芯片产品和专业的服务。我们深知HBM芯片在AI和GPU领域的重要性,也将不断努力,为您的技术创新和业务发展提供有力支持。

相信在未来,HBM芯片将继续在AI和GPU的驱动下,创造更多的技术突破和应用奇迹,其市场规模也有望随着AI等相关产业的发展进一步扩大。

让亿配芯城与您一同见证并参与这一激动人心的科技进程!

需要注意的是,市场规模的预测数据可能因统计机构、统计方法和市场变化等因素而有所不同,在实际应用中应综合参考多方面的信息和数据进行分析。同时,HBM市场还受到技术发展、竞争格局、宏观经济等多种因素的影响,其未来的发展趋势具有一定的不确定性。